ملف Robots.txt: كيف تتحدث مع زواحف جوجل

في مقالاتنا السابقة عن “كيف تعمل محركات البحث” و “السيو التقني”، قدمنا ملف robots.txt على أنه “حارس بوابة” موقعك على الويب. إنه أول ملف يبحث عنه زاحف محرك بحث محترم، مثل Googlebot، عندما يزور موقعك.

على الرغم من أنه مجرد ملف نصي بسيط، إلا أنه يتمتع بقوة هائلة. إنه خط اتصالك الأول والمباشر مع الروبوتات التي تستكشف وتفهرس الويب.

يمكن لملف robots.txt مهيأ بشكل صحيح توجيه هذه الزواحف بكفاءة، في حين أن خطأ واحدًا يمكن أن يجعل موقعك بأكمله غير مرئي.

هذا المقال هو دليل التعليمات الكامل والمتعمق لهذا الحارس.

سنتجاوز الأساسيات لفهم بناء الجملة، التوجيهات المتقدمة، أفضل الممارسات، والأخطاء الحاسمة التي يجب تجنبها.

ما هو ملف robots.txt وأين يوجد؟ (مفرش الترحيب ودليل القواعد)

قبل أن يخطو أي زاحف لمحرك بحث خطوة واحدة داخل موقعك، فإنه يقوم بعمل بروتوكولي مهذب: يبحث عند “الباب الأمامي” مباشرة عن “مفرش ترحيب” خاص يسمى robots.txt.

هذا الملف الصغير هو فرصتك الأولى والأهم لوضع القواعد الأساسية وتوجيه هؤلاء الزوار الآليين.

ما هو بالتحديد؟ بروتوكول وليس مجرد ملف

الاسم التقني هو “بروتوكول استبعاد الروبوتات” (Robots Exclusion Protocol). من المهم فهم أنه “بروتوكول” أو “معيار” طوعي.

التشبيه: فكر فيه على أنه لافتة “الرجاء خلع حذائك قبل الدخول” التي تضعها على باب منزلك.

الزوار المهذبون (مثل Googlebot, Bingbot): سيقرؤون اللافتة دائمًا ويحترمون طلبك.

الزوار المزعجون (مثل روبوتات جمع البريد الإلكتروني أو البرامج الضارة): سيتجاهلون اللافتة تمامًا ويدخلون بأحذيتهم المتسخة.

الخلاصة: robots.txt هو أداة لتوجيه الزواحف “الجيدة”، وليس أداة أمان لمنع الزواحف “السيئة”.

الملف نفسه هو مجرد ملف نصي عادي (Plain Text)، مما يعني أنه لا يحتوي على أي أكواد HTML أو تصميم.

هو مجرد قائمة من التعليمات البسيطة والمباشرة.

الموقع الحاسم: الدليل الجذر (The Root Directory)

هذا هو الجزء الأكثر أهمية. الزواحف مبرمجة للبحث عن هذا الملف في مكان واحد فقط لا غير: الدليل الجذر لموقعك.

التشبيه: إذا كان موقعك عبارة عن “قلعة” ضخمة، فإن الزواحف لن تبحث عن دليل القواعد في كل غرفة.

هي ستذهب مباشرة إلى “البوابة الرئيسية” وتتوقع أن تجد القواعد معلقة هناك. إذا لم تجد أي شيء، فإنها تفترض أن لديها الإذن الكامل لدخول كل مكان.

ماذا يعني هذا عمليًا؟

يجب أن يكون ملف robots.txt الخاص بك متاحًا دائمًا على الرابط yourdomain.com/robots.txt. لا يمكنك وضعه في مجلد فرعي مثل yourdomain.com/blog/robots.txt.

قاعدة الملف الواحد: لا يمكن أن يكون لديك سوى ملف robots.txt واحد فقط لكل نطاق أساسي (أو نطاق فرعي).

هذا الملف الواحد يجب أن يحتوي على كل التوجيهات لجميع أجزاء موقعك.

كيف تتحقق بنفسك؟

جرب الآن: افتح تبويبًا جديدًا واكتب عنوان أي موقع كبير متبوعًا بـ /robots.txt (مثال: https://www.google.com/robots.txt أو https://www.wikipedia.org/robots.txt).

سترى مباشرة “دليل القواعد” الذي وضعوه لزواحف محركات البحث.

لغة الروبوتات: فهم بناء الجملة (Syntax)

بعد أن عرفنا في القسم السابق ما هو ملف robots.txt وأين يوجد، حان الوقت لنتعلم “لغته”.

هذه اللغة بسيطة جدًا وتعتمد على مجموعة من الأوامر تسمى “التوجيهات” (Directives).

التشبيه: فكر في الأمر كأنك تكتب “دليل تعليمات” لروبوت زائر. الروبوت حرفي جدًا وسيتبع تعليماتك بدقة، لذا يجب أن تكون واضحًا.

يتكون الدليل من “مجموعات قواعد”، كل مجموعة مخصصة لنوع معين من الروبوتات.

الهيكل الأساسي: مجموعات القواعد

يتكون الملف من مجموعة واحدة أو أكثر من القواعد. تبدأ كل مجموعة دائمًا بتحديد User-agent، متبوعًا بقواعد Disallow أو Allow الخاصة به.

1. User-agent: تحديد من تخاطب

التشبيه: هذا التوجيه يشبه كتابة “اسم المستلم” في أعلى المذكرة الداخلية. كل التعليمات التي تأتي بعده موجهة إلى هذا المستلم المحدد، حتى تصل إلى اسم مستلم جديد.

كيف يعمل؟

أنت تحدد اسم الزاحف الذي تريد إعطاءه التعليمات.

User-agent: *النجمة *

هي حرف بدل يعني “إلى كل من يهمه الأمر”. هذه التعليمات تنطبق على جميع الزواحف التي لم يتم تحديد تعليمات خاصة بها.

يجب أن تبدأ ملفك دائمًا بمجموعة قواعد عامة لهذا الوكيل.

User-agent: Googlebot

هذه التعليمات موجهة فقط لزاحف جوجل الرئيسي. سيتجاهلها زاحف Bing.

User-agent: Bingbot

هذه التعليمات موجهة فقط لزاحف Bing.

2. Disallow: وضع لافتة “ممنوع الدخول”

التشبيه: هذا هو الأمر المباشر الذي يضع لافتة “ممنوع الدخول” على باب غرفة أو ممر معين.

كيف يعمل؟

أنت تحدد المسار (Path) الذي لا تريد من الزاحف المحدد في User-agent أن يدخله. تذكر أن المسار حساس لحالة الأحرف ويبدأ دائمًا بشرطة مائلة /.

Disallow: /admin/

(امنع الدخول إلى مجلد /admin/ وكل ما بداخله).

Disallow: /private-page.html

(امنع الدخول إلى هذا الملف المحدد فقط).

Disallow: /

(تحذير: هذا يعني “امنع الدخول إلى الموقع بأكمله”).

3. Allow: إنشاء استثناءات وتصاريح خاصة

التشبيه: هذا التوجيه يشبه إعطاء “تصريح دخول خاص” لشخص ما لدخول غرفة معينة داخل قسم تم منعه من دخوله بالكامل.

كيف يعمل؟

قوة Allow تظهر فقط عند استخدامها مع Disallow. وظيفتها هي إنشاء استثناء.

سيناريو عملي: تخيل أن لديك مجلدًا اسمه /assets/ يحتوي على ملفات PDF وملفات صور. أنت تريد أن تمنع جوجل من الزحف إلى ملفات PDF، لكنك تريد السماح له بالزحف إلى الصور.

يمكنك كتابة القاعدة التالية:

User-agent: Googlebot

Disallow: /assets/ # أولاً، امنع المجلد بأكمله

Allow: /assets/images/ # ثانيًا، أنشئ استثناءً لمجلد الصور بداخلههذا يمنحك تحكمًا دقيقًا جدًا في سلوك الزاحف.

4. Sitemap: إرشاد الزاحف إلى خريطة الطريق

التشبيه: هذا التوجيه ليس قاعدة، بل هو “ملاحظة مفيدة” تتركها لجميع الزوار الآليين في مكتب الاستقبال، تقول لهم: “إذا كنتم تبحثون عن الخريطة الكاملة للمبنى، فهي موجودة في هذا العنوان”.

كيف يعمل؟

هذا التوجيه مستقل عن أي User-agent. ببساطة، تقوم بوضع المسار الكامل لخريطة موقعك. هذا يساعد جميع محركات البحث (وليس فقط الذي حددته في User-agent) على اكتشاف خريطة موقعك بسهولة وسرعة.

Sitemap: https://www.example.com/sitemap.xml

الخلاصة:

هذه التوجيهات البسيطة الأربعة، عند دمجها معًا، تشكل لغة قوية ودقيقة للتحكم في سلوك الزاحف.

هي تسمح لك بحماية الأقسام الخاصة، إدارة ميزانية الزحف، وتقديم خريطة واضحة، مما يشكل أساس استراتيجية التواصل الرسمية بين موقعك ومحركات البحث.

التحكم المتقدم: إتقان لغة الروبوتات باستخدام أحرف البدل

بعد أن تعلمنا “المفردات” الأساسية لملف robots.txt، ننتقل الآن إلى “القواعد النحوية” المتقدمة التي تمنحك قوة ومرونة أكبر بكثير في توجيه الزواحف.

بدلاً من كتابة عشرات القواعد المنفصلة، يمكنك استخدام رمزين خاصين لإنشاء قواعد ديناميكية وفعالة.

1. النجمة *: حرف “املأ الفراغ”

التشبيه: النجمة * تعمل كأمر “املأ الفراغ” أو “طابق أي شيء”. هي تطابق أي سلسلة من الأحرف.

حالات الاستخدام العملية:

حظر مجلد وكل محتوياته

Disallow: /search/*

هذه القاعدة تخبر الزاحف: “امنع أي رابط يبدأ بـ /search/ بغض النظر عن ما يأتي بعده”.

هذا مثالي لحظر أقسام كاملة مثل صفحات نتائج البحث الداخلية، التي لا قيمة لها في فهرس جوجل وتستنزف ميزانية الزحف.

حظر جميع الروابط التي تحتوي على معلمات (الأكثر قوة)

Disallow: /

*?

هذا السطر الصغير هو واحد من أقوى القواعد التي يمكنك استخدامها، خاصة للمتاجر الإلكترونية. علامة الاستفهام ? هي التي تبدأ “سلسلة الاستعلام” في الـ URL.

هذه القاعدة تعني: “امنع أي رابط يحتوي على علامة استفهام”. هذا يمنع الزواحف من الضياع في عدد لا نهائي من الروابط التي يتم إنشاؤها عبر الفرز والتصفية (مثل ?color=blue&size=large).

2. علامة الدولار $: قاعدة “النهاية فقط”

التشبيه: علامة الدولار $ تعمل كـ “مرساة” تثبت القاعدة في نهاية الرابط تمامًا. هي تخبر الزاحف: “طبق هذه القاعدة فقط إذا كان هذا النمط هو نهاية الرابط بالضبط”.

حالات الاستخدام العملية:

حظر أنواع ملفات معينة بدقة

لنفترض أنك تريد منع الزحف إلى كل ملفات PDF على موقعك.

الطريقة الخطأ: Disallow: /*.pdf

هذه القاعدة قد تمنع عن طريق الخطأ صفحة مهمة مثل /learn-about-pdf-files.

الطريقة الصحيحة:

Disallow: /*.pdf$إضافة علامة $ تضمن أن القاعدة لن تُطبق إلا على عناوين URL التي تنتهي بالضبط بـ .pdf.

إنشاء قواعد دقيقة

تخيل أن لديك ملفًا اسمه /login وتريد حظره، ولكن لديك أيضًا مجلدًا اسمه /login/dashboard وتريد السماح به.

الطريقة الخطأ: Disallow: /login

هذه القاعدة ستحظر كليهما لأن كليهما يبدأ بـ /login.

الطريقة الصحيحة:

Disallow: /login$إضافة $ تخبر الزاحف بحظر الرابط الذي ينتهي بـ /login فقط، ولن يؤثر ذلك على المجلد /login/dashboard.

بالتأكيد. إليك إعادة صياغة مفصلة وموسعة لهذا القسم، مع ربطه بشكل أعمق بالمفاهيم السابقة.

أفضل الممارسات والأخطاء الحاسمة التي يجب تجنبها

بعد أن تعلمنا “لغة” الروبوتات وقواعدها المتقدمة، ننتقل الآن إلى “الحكمة”. استخدام robots.txt يشبه عمل الجراح؛ الدقة مطلوبة، وخطأ بسيط يمكن أن يسبب ضررًا كبيرًا.

فهم الأخطاء الشائعة لا يقل أهمية عن فهم القواعد الصحيحة.

1. الخطأ الكارثي: Disallow: / (زر التدمير الذاتي)

هذا ليس مجرد خطأ، بل هو أمر تدميري.

التشبيه: كتابة Disallow: / في ملفك يشبه “صب جدار خرساني يسد المدخل الرئيسي لناطحة السحاب الخاصة بك”.

لا يهم كم هي رائعة من الداخل؛ لم يعد بإمكان أي شخص الدخول.

التأثير التقني

الشرطة المائلة الواحدة / تمثل الدليل الجذر، أي نقطة البداية لموقعك بأكمله. هذا الأمر يخبر كل زاحف محرك بحث: “ممنوع منعًا باتًا الزحف إلى أي جزء من هذا النطاق”.

النتيجة الحتمية هي أن صفحات موقعك ستبدأ بالاختفاء تدريجيًا من فهرس جوجل، وستخسر كل حركة مرورك العضوية.

تجنب هذا السطر بأي ثمن إلا إذا كنت تريد إخفاء موقعك عن العالم عمدًا.

2. الخلط القاتل بين الزحف والفهرسة (robots.txt مقابل noindex)

هذه هي النقطة الأكثر أهمية وإرباكًا للمبتدئين، وفهمها هو علامة على نضجك كخبير سيو.

التشبيه

ملف robots.txt

هو وضع لافتة “ممنوع التجاوز” على بوابة حديقتك الخارجية. الزاحف المهذب (Googlebot) سيرى اللافتة ولن يدخل.

هو لا يعرف أبدًا ما يوجد داخل منزلك.

لكن، إذا كان جيرانك (مواقع أخرى) يتحدثون باستمرار عن منزلك ويشيرون إليه، فقد يضيف “مخطط المدينة” (فهرس جوجل) موقع منزلك إلى الخريطة مع ملاحظة “لم نتمكن من الدخول للتحقق”.

وسم الميتا noindex

هو لافتة تضعها داخل باب منزلك تقول: “هذه الغرفة خاصة، يرجى عدم إدراجها في أي دليل عام.”.

لكي يرى الزاحف هذه اللافتة، يجب أن تسمح له بدخول الحديقة والوصول إلى باب المنزل أولاً (أي، عدم حظر الصفحة في robots.txt).

المشكلة العملية

إذا قمت بحظر صفحة في robots.txt، لكن كانت هناك روابط خارجية تشير إليها، فقد تكتشفها جوجل وتفهرسها دون أن تزحف إليها.

النتيجة هي ظهور كارثي في نتائج البحث: رابط أزرق لصفحتك، ولكن مع وصف يقول “لا توجد معلومات متاحة لهذه الصفحة” أو “وصف هذه النتيجة غير متوفر بسبب ملف robots.txt الخاص بهذا الموقع.”

هذا يبدو غير احترافي ويقدم تجربة سيئة للمستخدم.

الحل الصحيح

لمنع صفحة من الظهور في جوجل بشكل موثوق: استخدم وسم الميتا noindex في قسم الخاص بالصفحة، وتأكد من أن الصفحة غير محظورة في robots.txt.

name="robots" content="follow, noindex">

noindex. يشير التقرير إلى أن هذا التوجيه سيمنع محركات البحث، مثل جوجل، من فهرسة الصفحة، مما يضمن عدم ظهورها في نتائج البحث.لمنع جوجل من إهدار “ميزانية الزحف” على قسم غير مهم (لا تهتم إذا تم فهرسته أم لا): استخدم robots.txt.

3. حظر ملفات CSS و JavaScript (جريمة في حق الويب الحديث)

صلته بما سبق

كما تعلمنا في مقالاتنا عن “متصفح الويب” و “آلية عمل محركات البحث“، فإن جوجل لم يعد يقرأ النصوص فقط؛ بل يستخدم نسخة مصغرة من متصفح كروم لعرض (Rendering) الصفحات بالكامل ليفهمها كما يراها المستخدم.

التشبيه

حظر ملفات CSS و JavaScript يشبه دعوة ناقد طعام مهم (Googlebot) إلى مطعمك، ثم عصب عينيه ووضع سدادات في أذنيه.

يمكنه “تذوق” الطعام (كود HTML الخام)، لكنه لا يستطيع رؤية “جمال التقديم” (التصميم عبر CSS) أو تجربة “الأجواء والخدمة” (التفاعلية عبر JavaScript).

التأثير المدمر

سيقوم الناقد بكتابة مراجعة بناءً على ما اختبره: وجبة بلا شكل أو مظهر. وبالمثل، سيرى جوجل صفحة نصية غير منسقة ومكسورة.

سيفترض أن هذه هي تجربة المستخدم السيئة التي تقدمها، وقد يستنتج أن المحتوى مخفي أو أن الموقع غير متوافق مع الجوال.

كل هذه إشارات سلبية قوية يمكن أن تدمر ترتيبك.

القاعدة الذهبية اليوم: اسمح دائمًا بالزحف إلى جميع ملفات CSS و JS الضرورية لعرض موقعك بشكل صحيح.

كيف تختبر ملف robots.txt الخاص بك؟ (الطريقة الحديثة)

بعد أن رأينا في القسم السابق كيف أن خطأ واحدًا في ملف robots.txt يمكن أن يكون كارثيًا، يظل السؤال قائمًا: “كيف أتأكد من أنني لم أرتكب خطأً؟”.

على الرغم من أن أداة الاختبار الشاملة القديمة من جوجل قد اختفت، إلا أنك لست مضطرًا للتخمين.

سير العمل الحديث لاختبار ملف robots.txt الخاص بك هو عملية من جزأين: أولاً، التحقق من كيفية رؤية جوجل لملفك الحالي، وثانيًا، استخدام أدوات خارجية لاختبار التغييرات قبل نشرها.

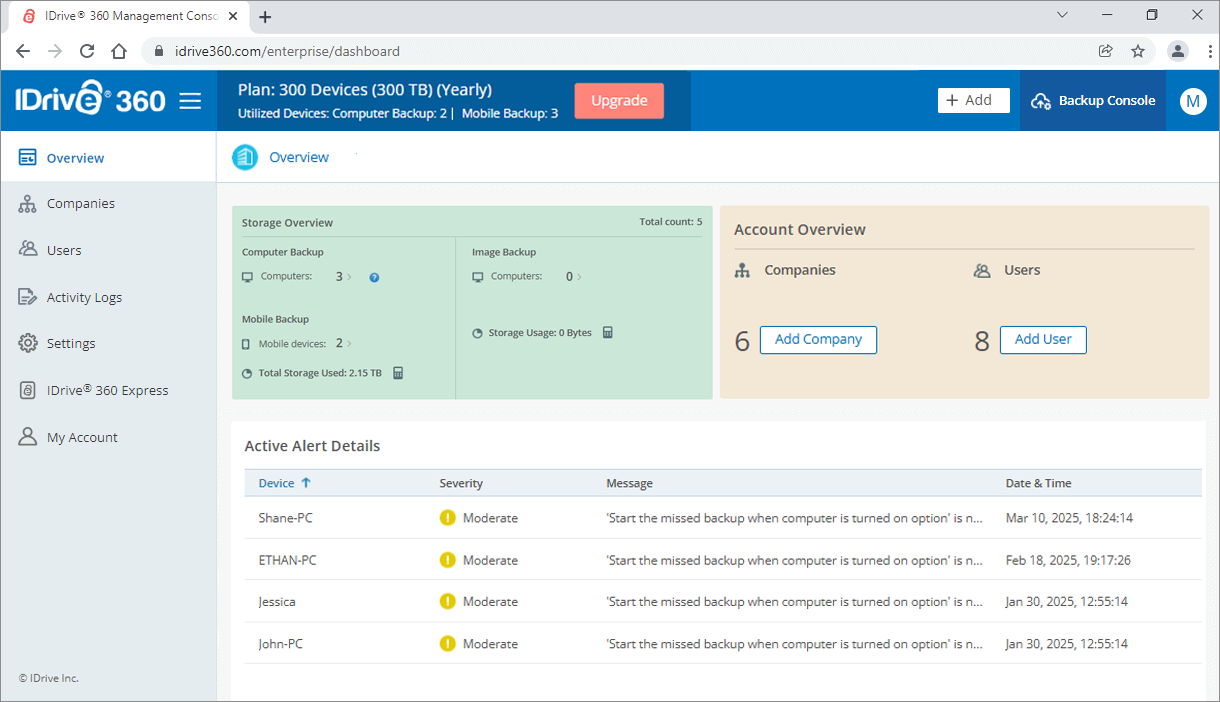

1. الطريقة الرسمية: التحقق من ملفك المنشور عبر Google Search Console

Google Search Console هو مصدر الحقيقة لمعرفة كيف يتفاعل جوجل مع ملف robots.txt الموجود على موقعك.

تقرير robots.txt

كيفية الوصول إليه: سجل الدخول إلى حسابك في Google Search Console، اذهب إلى الإعدادات في القائمة اليسرى، وتحت قسم “الزحف”، ستجد تقرير robots.txt.

ماذا يُظهر: يعرض لك هذا التقرير النسخة الدقيقة من ملف robots.txt التي رآها زاحف جوجل آخر مرة، ومتى رآها، وما إذا واجه أي أخطاء في بناء الجملة.

هذا هو “الفحص الصحي” للتأكد من أن جوجل يقرأ ملفك المنشور بشكل صحيح.

أداة فحص عنوان URL (URL Inspection Tool)

هذه هي الطريقة الحديثة لاختبار ما إذا كان عنوان URL معين محظورًا.

كيف تعمل:

1. أدخل أي عنوان URL من موقعك في شريط البحث أعلى Google Search Console.

2. بعد أن تقوم الأداة بتحليل الصفحة، افتح قسم “الزحف” في التقرير.

3. ابحث عن سطر “هل الزحف مسموح به؟”. سيعطيك إجابة واضحة “نعم” أو “لا”. إذا كانت الإجابة “لا”، فسيذكر أن الصفحة محظورة بواسطة ملف robots.txt.

noindex في وسم robots meta tag، رغم أن عملية الزحف مسموحة (Crawl allowed: Yes).

2. الطريقة العملية: اختبار القواعد الجديدة قبل نشرها (باستخدام أدوات خارجية)

القصور الأكبر في تقارير Search Console الجديدة هو أنها لا تسمح لك باختبار التغييرات أو القواعد الجديدة في “صندوق رمل” آمن قبل نشرها. للقيام بذلك، نعتمد الآن على أدوات خارجية ممتازة.

كيف تعمل: العملية بسيطة جدًا:

1. ابحث عن “robots.txt tester” عبر الإنترنت. هناك العديد من الأدوات المجانية الرائعة المتاحة من مواقع السيو الموثوقة مثل TechnicalSEO.com أو Merkle.

2. الصق المحتوى الكامل لملف robots.txt الجديد الذي تقترحه في محرر الأداة.

3. أدخل قائمة بعناوين URL النموذجية من موقعك التي تريد اختبارها مقابل هذه القواعد الجديدة (على سبيل المثال، صفحة تنوي حظرها، وصفحة تريد التأكد من أنها لا تزال مسموحة).

4. قم بتشغيل الاختبار. ستقوم الأداة بمحاكاة كيفية تفسير الزاحف لقواعدك وتعطيك نتيجة واضحة “مسموح به” أو “محظور” لكل عنوان URL.

القاعدة الذهبية الآن هي: اختبر دائمًا تغييرات robots.txt الخاصة بك في أداة خارجية قبل رفعها إلى خادمك، ثم تحقق من أن جوجل يراها بشكل صحيح في Search Console.

كيفية إنشاء وتعديل ملف robots.txt الخاص بك

لقد أتقنت الآن “لغة” الروبوتات، وتعلمت كيف تختبر قواعدك. نصل الآن إلى الخطوة العملية الأخيرة: كيف تنشئ أو تعدل هذا الملف على موقعك الفعلي؟ الطريقة تعتمد بشكل أساسي على نوع المنصة التي تستخدمها.

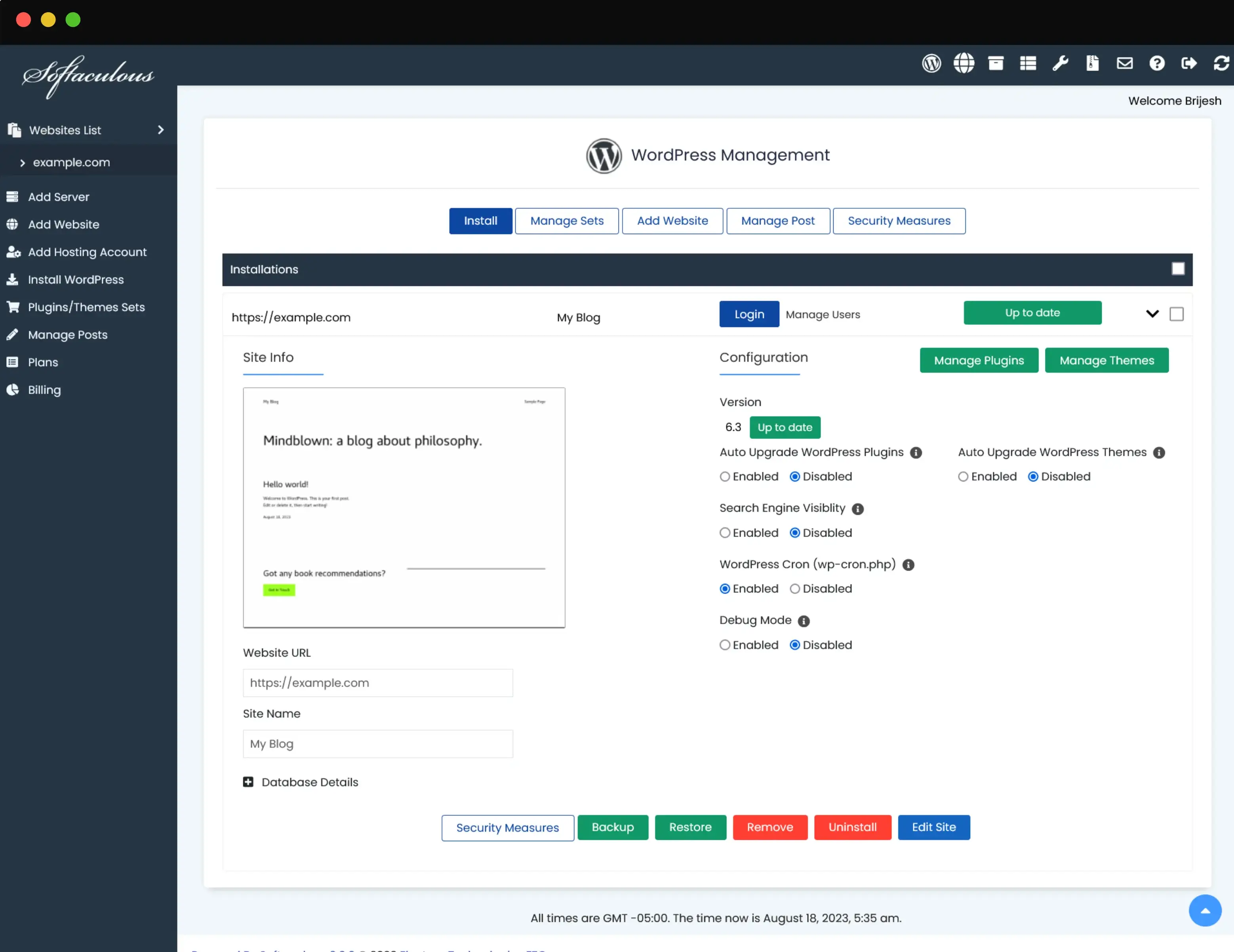

الطريقة الأسهل: لمستخدمي ووردبريس (عبر إضافة سيو)

إذا كان موقعك مبنيًا على ووردبريس، فالأمر سهل جدًا ولا يتطلب أي تعامل مباشر مع الملفات.

لماذا؟ لأن إضافات السيو الشهيرة (مثل Yoast SEO أو Rank Math) تقوم بإنشاء “ملف robots.txt افتراضي” لك وتمنحك واجهة سهلة لتعديله.

الخطوات العملية (باستخدام Rank Math كمثال)

- من لوحة تحكم ووردبريس، اذهب إلى

Rank Math>General Settings. - اختر

Edit robots.txt. - ستجد محرر نصوص يحتوي على القواعد الحالية. يمكنك إضافة أو تعديل أي قاعدة تريدها مباشرة في هذا المربع.

- انقر على

Save Changes.

هذا كل شيء! ستقوم الإضافة بالتعامل مع كل الجوانب التقنية في الخلفية. (توجد خطوات مشابهة جدًا في إضافة Yoast SEO).

الطريقة اليدوية: للمواقع المخصصة أو الاستضافة بدون ووردبريس

إذا كان موقعك عبارة عن ملفات HTML و CSS ثابتة، أو كنت لا تستخدم إضافة سيو، فستحتاج إلى إنشاء الملف ورفعه يدويًا.

العملية بسيطة وتتكون من الخطوات التالية:

1. إنشاء الملف

افتح أي محرر نصوص بسيط على جهاز الكمبيوتر الخاص بك (مثل Notepad في ويندوز، أو TextEdit في ماك، أو VS Code).

مهم جدًا: تأكد من أنك تعمل في وضع “النص العادي” (Plain Text)، وليس Rich Text.

2. كتابة القواعد

اكتب توجيهاتك في الملف الفارغ. يمكنك البدء بشيء بسيط جدًا وآمن مثل:

User-agent: *

Disallow: /wp-admin/

Sitemap: https://www.yourdomain.com/sitemap.xml3. حفظ الملف

- احفظ الملف بالاسم

robots.txtبالضبط. - تأكد من أن الاسم مكتوب بأحرف صغيرة.

- تأكد من أن امتداد الملف هو

.txt.

4. رفع الملف إلى الخادم

يجب عليك الآن رفع هذا الملف إلى الدليل الجذر (Root Directory) لموقعك. هذا هو نفس المجلد الذي يحتوي على صفحتك الرئيسية، ويسمى عادة public_html.

صلته بالمقالات السابقة: يمكنك استخدام إحدى الطريقتين اللتين تعلمناهما في مقال cPanel:

1. باستخدام مدير الملفات في cPanel: سجل الدخول إلى cPanel، اذهب إلى File Manager، افتح مجلد public_html، ثم انقر على Upload لرفع ملف robots.txt الذي أنشأته.

2. باستخدام FTP: إذا كنت تفضل، يمكنك استخدام عميل FTP (مثل FileZilla) للاتصال باستضافتك ورفع الملف إلى الدليل الجذر.

robots.txt مباشرة، والذي يتضمن توجيهات لمنع زحف روبوتات محركات البحث عن مجلدات معينة (Disallow: /wp-admin/) وإشارة إلى خريطة الموقع (Sitemap).

5. التحقق النهائي

بعد رفع الملف، افتح متصفحك واذهب إلى yourdomain.com/robots.txt. يجب أن ترى المحتويات التي كتبتها للتو.

الاستفادة من الذكاء الاصطناعي: مساعدك الذكي لملف robots.txt

كما رأينا في مقالاتنا الأخيرة، يعيد الذكاء الاصطناعي تشكيل سير عمل السيو.

وعلى الرغم من أن ملف robots.txt يتطلب دقة، يمكن للذكاء الاصطناعي أن يعمل “كمساعد طيار” ذكي لك لتبسيط العملية وتقليل فرصة حدوث الأخطاء.

إليك طريقتان قويتان للاستفادة من الذكاء الاصطناعي عند التعامل مع ملف robots.txt الخاص بك:

1. استخدام الذكاء الاصطناعي للتدقيق والشرح

تخيل أنك استلمت موقعًا جديدًا يحتوي على ملف robots.txt كبير ومعقد لا تفهمه بالكامل.

العملية

يمكنك ببساطة نسخ المحتوى الكامل لملف robots.txt ولصقه في نموذج دردشة ذكاء اصطناعي (مثل ChatGPT أو Gemini) مع أمر بسيط:”تصرف كخبير سيو تقني.

يرجى تحليل ملف robots.txt هذا، وشرح كل مجموعة قواعد بلغة بسيطة، وإخباري إذا كان هناك أي مشاكل محتملة أو فرص للتحسين.”

النتيجة

سيقدم لك الذكاء الاصطناعي تفصيلاً سطراً بسطر لما يفعله ملفك. يمكنه اكتشاف القواعد المكررة، تحديد أوامر Disallow التي قد تكون خطيرة، وإعطائك فهمًا واضحًا لإعدادك الحالي في ثوانٍ.

2. استخدام الذكاء الاصطناعي لإنشاء الملف

إذا كنت تبدأ من الصفر، فلست بحاجة إلى حفظ بناء الجملة. يمكنك ببساطة وصف احتياجاتك للذكاء الاصطناعي بلغة عادية.

العملية

يمكنك إعطاء الذكاء الاصطناعي أمرًا مثل هذا:

“أنا أقوم بإنشاء ملف robots.txt لموقع ووردبريس الجديد الخاص بي.

أريد حظر جميع الزواحف من دليل /wp-admin/.

أريد السماح بالزحف إلى دليل /wp-content/uploads/.

خريطة موقعي موجودة في https://www.mywebsite.com/sitemap.xml.

من فضلك، أنشئ لي ملف robots.txt نظيفًا ومعلقًا عليه بشكل جيد.”

النتيجة

سيقوم الذكاء الاصطناعي على الفور بإنشاء ملف robots.txt كامل ومنسق وجاهز للاستخدام يتبع أفضل الممارسات، بما في ذلك بناء الجملة الصحيح والتعليقات.

القاعدة الذهبية (تحذير حاسم)

بينما يعد الذكاء الاصطناعي مساعدًا قويًا بشكل لا يصدق، إلا أنه ليس معصومًا من الخطأ.

لا تقم أبدًا بنسخ ولصق ملف robots.txt تم إنشاؤه بواسطة الذكاء الاصطناعي بشكل أعمى ورفعه إلى موقعك المباشر.

دائمًا استخدم أساليب الاختبار التي وصفناها في القسم السابق (باستخدام Google Search Console والأدوات الخارجية) للتحقق من أن الكود الذي تم إنشاؤه بواسطة الذكاء الاصطناعي يفعل بالضبط ما تتوقعه منه.

الذكاء الاصطناعي هو مساعدك، لكنك أنت الخبير وصاحب القرار النهائي.

أنت الآن المتحكم

في هذا الدليل الشامل، قمنا بتشريح ملف robots.txt بالكامل، من أبسط قواعده إلى توجيهاته المتقدمة.

لقد تعلمت ليس فقط “لغة” الروبوتات، بل تعلمت أيضًا “حكمة” استخدامها: كيف توجه الزواحف بكفاءة، وكيف تتجنب الأخطاء الكارثية، والأهم من ذلك، كيف تختبر عملك بأمان قبل نشره.

تذكر دائمًا أن robots.txt هو أداة للتحكم في الزحف، وليس الفهرسة. إنه “دليل التعليمات” الذي تقدمه للزوار الآليين، وليس “بابًا فولاذيًا” يمنع المحتوى من الظهور.

إتقانك لهذه الأداة، واستخدامها بتناغم مع الأدوات الأخرى مثل وسم noindex وخرائط الموقع، هو ما يضعك في مقعد القيادة.

لم تعد الآن تحت رحمة كيفية تفسير محركات البحث لموقعك بشكل عشوائي.

بامتلاكك لهذه المعرفة، أصبحت قادرًا على إجراء حوار منظم وواضح مع جوجل وغيره من محركات البحث، وتوجيههم بدقة، ووضع أساس تقني-سليم لاستراتيجية السيو الخاصة بك.